مایکروسافت هم مانند گوگل ، تجربیات و مستنداتی خودش رو در خصوص تیم قرمز هوش مصنوعیش منتشر کرده، تا علاقمندان بتونن ایده های اولیه رو از اون بگیرن.

تیم قرمز بعنوان یکی از بخش های ایمنی نرم افزار، بطور گسترده به تمرین شبیه سازی شده از دشمنان دنیای واقعی و ابزارها، تاکتیکها و رویههای اونا برای شناسایی خطرات، کشف نقاط کور، اعتبارسنجی فرضیات و بهبود وضعیت امنیتی کلی سیستمها اشاره داره.

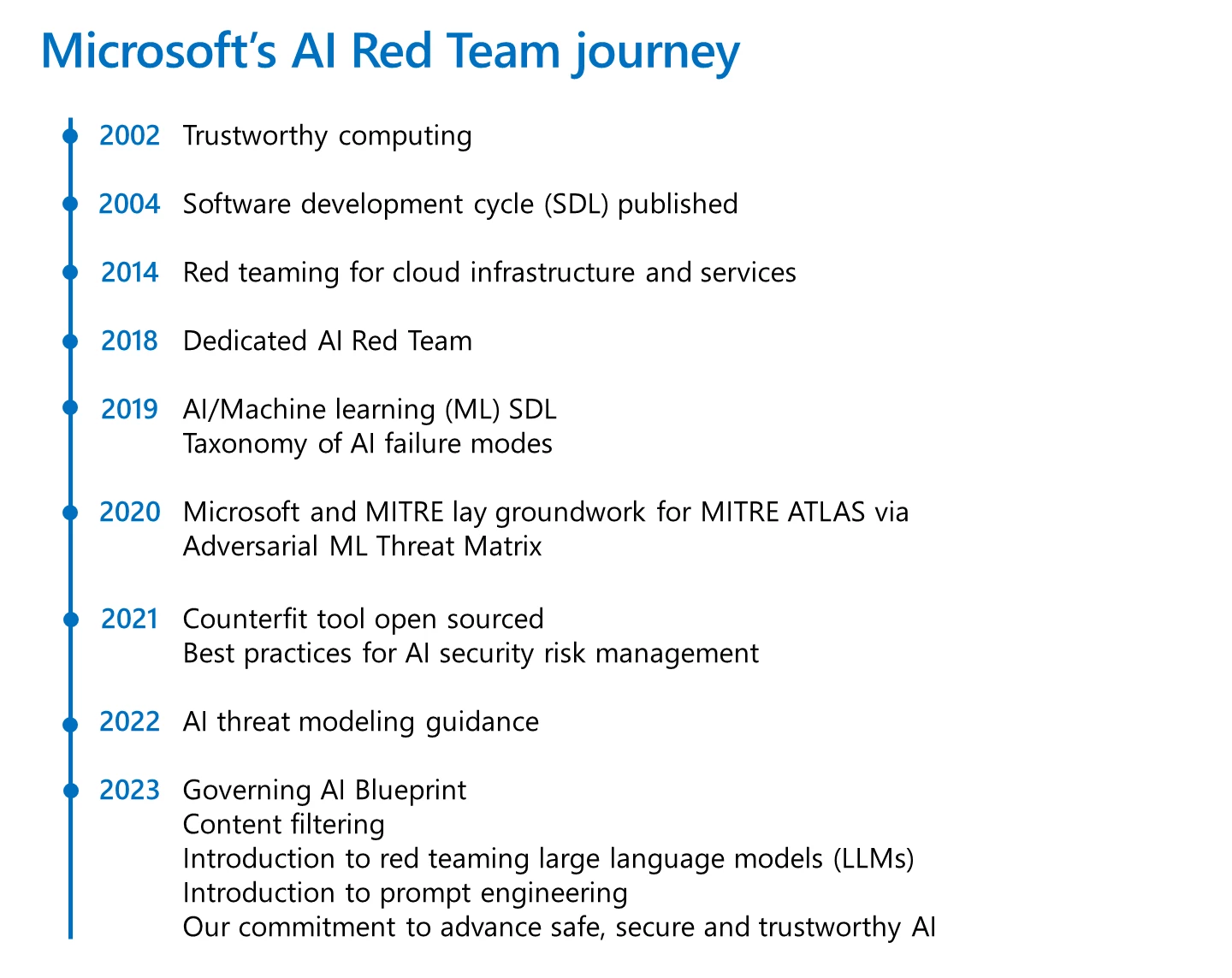

مایکروسافت سابقه طولانی در استفاده از تیم های قرمز با هدف ،کشف پیشگیرانه مشکلات و خرابی ها در فناوری داره. با گسترش هوش مصنوعی، مایکروسافت در سال 2018 ، تیم قرمزش رو برای هوش مصنوعی ایجاد کرد، یه گروه از کارشناسان بین رشته ای که مانند مهاجمین فکر میکنن و خرابی ها رو در سیستم های هوش مصنوعی بررسی میکنن.

ایجاد تیم قرمز معنی گسترده تری داره، اینا نه تنها آسیب پذیری های امنیتی رایج رو پوشش میدن، بلکه خرابی های دیگه ای مانند تولید محتوای بالقوه مضر رو هم پوشش میدن.

سیستم های هوش مصنوعی ، خطرات جدیدی رو بهمراه آوردن و ایجاد تیم قرمز هوش مصنوعی ، هسته اصلی درک این خطرات هستش.

تیم قرمز هوش مصنوعی فقط مختص مایکروسافت نیست. این سنگ بنای هوش مصنوعی مسئولانه از نظر طراحی هستش، همونطور که Brad Smith، رئیس و نایب رئیس مایکروسافت اعلام کرده، مایکروسافت اخیرا متعهد شده که تمام سیستمهای هوش مصنوعی پرخطر رو قبل از استقرار، از طریق تیمهای قرمز مستقل ، ارزیابی میکنه.

مایکروسافت گفته که در این چند سال اخیر، تیم قرمز هوش مصنوعیش بصورت مداوم محتوا تولید میکرده تا متخصصین امنیتی بطور جامع و پیشگیرانه در مورد چگونگی پیاده سازی ایمن هوش مصنوعی تفکر کنن. در اکتبر 2020، مایکروسافت بهمراه MITRE و همچنین شرکای صنعتی و دانشگاهی ، Adversarial Machine Learning Threat Matrix رو توسعه و منتشر کرد که یه چارچوب برای توانمندسازی تحلیلگران امنیتی برای شناسایی، پاسخگویی و اصلاح تهدیدات هستش. همچنین در سال 2020 ، مایکروسافت Microsoft Counterfit رو بصورت متن باز ایجاد کرد که یه ابزار اتوماسیون برای تست امنیت سیستمهای هوش مصنوعی برای بهبود امنیتی راه حل های هوش مصنوعی هستش. در ادامه در سال 2021 ، چارچوب ارزیابی ریسک امنیتی هوش مصنوعی رو منتشر کرد تا عملکردهای امنیتی خودشون رو هم در مورد امنیت سیستمهای هوش مصنوعی توسعه بدن. اوایل امسال هم یسری کارهای دیگه در این خصوص انجام دادن از جمله ادغام Counterfit در ابزار MITRE ، همکاری با Hugging Face ، در اسکنر امنیتی مختص هوش مصنوعی که در گیتهاب در دسترس هستش.

نمودار زیر عملکردهای مایکروسافت رو در خصوص امنیت هوش مصنوعی نشون میده :

ارزیابی امنیتی تیم قرمز هوش مصنوعی، بخشی از تلاش های تیم قرمز بزرگ هوش مصنوعی مسئولیت پذیر (RAI) هستش که بر اصول هوش مصنوعی مایکروسافت در مورد عدالت، قابلیت اطمینان و ایمنی، حریم خصوصی و امنیت، فراگیر بودن، شفافیت و مسئولیتپذیری تمرکز داره.

مایکروسافت در ادامه در خصوص تاثیر کار جمعی صحبت کرده و گفته که قبل از انتشار Bing chat ، تیمی متشکل از ده ها متخصص امنیتی و هوش مصنوعی ، صدها ساعت صرف بررسی امنیت و ریسک های هوش مصنوعی کردن. این ارزیابی علاوه بر بررسی امنیتی رایج نرم افزار، یه ارزیابی تیم قرمز ، روی مدل پایه GPT-4 ، توسط کارشناسان RAI ، قبل از توسعه Bing chat هم بوده.

دستورالعمل ها و منابع برای تیم های قرمز هوش مصنوعی:

فرایند تیم قرمز هوش مصنوعی در دو سطح انجام میشه : در سطح مدل پایه مثلا GPT-4 و سطح برنامه مثلا Copilot که در بک اند از GPT-4 استفاده میکنه.

هر دو سطح مزیتهایی دارن ، مثلا فرایند تیم قرمز در سطح مدل ، کمک میکنه تا در مراحل اولیه ، نحوه استفاده نادرست از مدل و دامنه قابلیت های مدل رو شناسایی و محدودیت های مدل رو درک کنیم. این بینش رو میشه به فرایند توسعه مدل برای بهبود نسخه های آتی مدل هم اضافه کرد و همچنین برای برنامه هایی که این فرایند برای اونا مناسبتره هم، اعمال کرد.

فرایند تیم قرمز هوش مصنوعی در سطح برنامه ، یه نمای سیستمی داره که مدل پایه بخشی از اون هستش. مثلا در فرایند تیم قرمز هوش مصنوعی روی Bing Chat ، فرایند جستجو توسط GPT-4 ارائه میشه و جزء دامنه بررسی بوده و مورد ارزیابی قرار گرفت. این به شناسایی خرابیها فراتر از مکانیسمهای ایمنی در سطح مدل، با گنجوندن محرکهای ایمنی خاص برنامه ، کمک میکنه.

بررسی امنیت و ریسک های هوش مصنوعی مسئولیت پذیر، تصویری واحد از اینکه چگونه تهدیدها و حتی استفاده از سیستم میتونه یکپارچگی، محرمانه بودن، در دسترس بودن و پاسخگویی سیستمهای هوش مصنوعی رو به خطر بندازه، ارائه میکنه. این دیدگاه ترکیبی از امنیت و هوش مصنوعی مسئولیت پذیر، بینشهای ارزشمندی رو نه تنها در شناسایی فعالانه مشکلات، بلکه برای درک شیوع اونا در سیستم ، از طریق اندازهگیری و اطلاعرسانی استراتژیهای کاهشی، ارائه میکنه.

در ادامه آموخته هایی که به شکل گیری برنامه تیم قرمز هوش مصنوعی مایکروسافت کمک کرده، اومده.

- تیم قرمز هوش مصنوعی گسترده تر هستش. ارزیابی تیم قرمز هوش مصنوعی ،بررسی امنیتی و RAI ،با هم هستش. فرآیند تیم قرمز هوش مصنوعی با اهداف تیم قرمز سنتی که در اون مولفه های امنیتی روی مدل بعنوان بردار متمرکز هستش ، تلاقی داره. بنابراین برخی از اهداف همچنان در این فرآیند هم هستش مانند سرقت مدل اصلی ولی سیستم های هوش مصنوعی یسری آسیب پذیری های جدیدی رو هم دارن ، مثلا prompt injection و poisoning ، که نیاز به توجه ویژه دارن. علاوه بر اهداف امنیتی، تیم قرمز هوش مصنوعی روی بررسی نتایج ،مثلا بررسی مسائل مرتبط با عدالت مانند stereotyping یا محتوای مضر مانند خشونت پراکنی، هم باید متمرکز بشه. تیم قرمز هوش مصنوعی به شناسایی زودهنگام این مسائل کمک میکنه تا بتونیم سرمایه گذاری های دفاعی خودمون رو بطور مناسب اولویت بندی کنیم.

- فرآیند تیم قرمز هوش مصنوعی روی خرابی های کاربران خوش خیم و بدخیم متمرکز هستش. مثلا در فرایند تیم قرمز Bing ، تیم قرمز هوش مصنوعی نه تنها روی تکنیکها و اکسپلویتهای مرتبط با امنیت، که مهاجم میتونه سیستم هوش مصنوعی رو به خطر بندازه، تمرکز داشت، بلکه روی ارائه محتوای مضر به یه کاربر عادی هم تمرکز داره. بنابراین، بر خلاف تیمهای قرمز امنیتی سنتی، که بیشتر روی دشمنان مخرب تمرکز دارن، فرآیند تیم قرمز هوش مصنوعی مجموعه گستردهتری از کاربران و شکستها رو در نظر میگیره.

- سیستم های هوش مصنوعی دائما در حال تکامل هستن. برنامه های کاربردی هوش مصنوعی بطور معمول تغییر میکنن. به عنوان مثال، در مورد یه برنامه کاربردی مدل زبان بزرگ، توسعه دهندگان ممکنه metaprompt (دستورالعمل های اصلی به مدل ML) رو بر اساس بازخورد تغییر بدن. در حالیکه سیستم های نرم افزاری سنتی هم تغییر می کنن، طبق تجربه ما، سیستم های هوش مصنوعی با سرعت بیشتری در حال تغییر هستن. بنابراین، انجام دوره های متعدد فرایند تیم قرمز سیستمهای هوش مصنوعی و ایجاد سیستمهای اندازهگیری و نظارت سیستماتیک، خودکار و در طول زمان ،مهم هستش.

- فرآیند تیم قرمز روی سیستم هوش مصنوعی مولد (generative AI systems) نیازمند تلاش های متعدد هستش. در یه تعامل تیم قرمز سنتی، استفاده از یه ابزار یا تکنیک در دو نقطه زمانی مختلف روی یه ورودی، همیشه خروجی یکسانی رو تولید میکنه. بعبارت دیگه، بطور کلی، تیم قرمز سنتی قطعیه. از طرف دیگه، سیستمهای هوش مصنوعی مولد، احتمالی هستن. یعنی دو بار اجرای یه ورودی ممکنه خروجی های متفاوتی ارائه بده. این به دلیل طراحیشون هستش، چون ماهیت احتمالی هوش مصنوعی مولد، اجازه میده تا طیف گسترده خلاقانه ای در خروجی داشته باشن. این امر همچنین فرایند تیم قرمز رو دشوار میکنه، چون ممکنه یه درخواست در اولین تلاش منجر به خرابی نشه، اما در تلاش بعدی منجر به خرابی بشه (در مواجهه با تهدیدات امنیتی یا آسیبهای RAI). در این خصوص Brad Smith گفته که، یکی از راه کارهای ما برای این موضوع اینه که چندین دور فرایند تیم قرمز رو در همون عملیات انجام بدیم. مایکروسافت همچنین روی اتوماسیون سرمایه گذاری کرده که به مقیاس عملیات و یه استراتژی اندازه گیری سیستمی که میزان خطر رو مشخص میکنه، کمک میکنه.

- اقدامات کاهشی روی هوش مصنوعی نیاز به دفاع عمیق داره. درست مانند امنیت سنتی که در اون مشکلی مانند فیشینگ به انواع اقدامات کاهشی فنی مانند hardening میزبان برای شناسایی هوشمند URI های مخرب نیاز داره، رفع خرابی هایی که از طریق تیم قرمز هوش مصنوعی کشف شدن هم ،نیازمند یه رویکرد دفاعی عمیق داره. این شامل استفاده از طبقهبندیکنندهها برای مشخص کردن محتوای بالقوه مضر برای استفاده از metaprompt ،برای هدایت رفتار به منظور محدود کردن انحراف مکالمه ، در سناریوهای مکالمه هستش.

هوش مصنوعی در حال شکل گیریه تا متحولترین فناوری قرن بیست و یکم باشه. و مانند هر فناوری جدید ، هوش مصنوعی در معرض تهدیدهای جدید هستش. کسب اعتماد مشتری با محافظت از محصولات ما همچنان یک اصل راهنما هستش که ما رو وارد این دوره جدید میکنه و تیم Red AI در جلو و مرکز این تلاش ها هستش.

منابع برای تیم قرمز هوش مصنوعی:

AI Red Teaming بخشی از استراتژی گسترده مایکروسافت برای ارائه سیستم های هوش مصنوعی ایمن و مسئولیت پذیر هستش. در اینجا منابع دیگه ای برای ارائه این بینش در مورد این فرآیند آورده شده :

برای مشتریانی که با استفاده از مدل های Azure OpenAI در حال ساخت برنامه های کاربردی هستن ، مایکروسافت راهنماهایی برای کمک به اونا در ایجاد تیم Red AI ، تعریف دامنه و اهداف و اجرا در deliveryها منتشر کرده.

برای پاسخ دهندگان حوادث امنیتی ، مایکروسافت یه bug bar ،برای تریاژ حملات روی سیستم های ML منتشر کرده.

برای مهندسان ML ، مایکروسافت یه چک لیستی برای تکمیل ارزیابی ریسک هوش مصنوعی منتشر کرده.

برای توسعه دهندگان ، مایکروسافت راهنماهایی مدل سازی تهدید ،بطور خاص برای سیستم های ML منتشر کرده.

برای هر کسی که علاقه مند به کسب اطلاعات بیشتر در مورد AI مسئولیت پذیره ، مایکروسافت نسخه ای از Responsible AI Standard and Impact Assessment، منتشر کرده.

برای مهندسان و سیاستگذاران ، مایکروسافت ، با همکاری Berkman Klein Center در دانشگاه هاروارد ، یه طبقه بندی رو منتشر کرده که حالت های مختلف عدم موفقیت در یادگیری ماشین رو مستند کرده.

برای جامعه امنیتی ، مایکروسافت میزبان مسابقه سالانه Machine Learning Evasion Competition بود.

برای مشتریان Azure Machine Learning ، مایکروسافت در مورد امنیت و حاکمیت سازمانی راهنمایی هایی رو منتشر کرده.