محققای Anthropic گزارشی منتشر کردن در خصوص یک کمپین با هدف جاسوسی، که 80 – 90 درصد کارهای تاکتیکی و فنی، بدون دخالت عامل انسانی و توسط هوش مصنوعی انجام شده. در این پست نگاهی به این گزارش جالب انداختیم.

در خصوص سوء استفاده از هوش مصنوعی توسط بازیگران تهدید، قبلا شرکتهای گوگل، مایکروسافت و OpenAI هم گزارشهایی منتشر کردن.

خلاصه اجرایی

Anthropic مجموعهای از سازوکارهای پیشرفته برای ایمنی و امنیت توسعه داده تا از سوء استفاده از مدلهای هوش مصنوعیشون جلوگیری کنه. با اینکه این تدابیر معمولا مؤثر هستن، اما مجرمان سایبری و سایر بازیگران تهدید همواره تلاش میکنن راههایی برای دور زدنشون پیدا کنن.

این گزارش، جزئیات یک کمپین تهدید اخیر رو که شناسایی و مختل کردن، همراه با اقداماتی که برای کشف و مقابله با این نوع سوء استفاده انجام دادن رو ارائه میده. این کار بخشی از فعالیتهای تیم اطلاعات تهدید (Threat Intelligence) هستش، تیمی متخصص در Anthropic که موارد واقعی سوءاستفاده رو بررسی میکنه و در کنار سازمان Safeguards برای بهبود دفاع در برابر چنین مواردی همکاری میکنه.

در اواسط سپتامبر ۲۰۲۵، محققای Anthropic، یک عملیات جاسوسی سایبری بسیار پیچیده رو شناسایی کردن که توسط یک گروه وابسته به دولت چین انجام میشده. گروهی که محققا اون رو GTG-1002 نامگذاری کردن. این عملیات نشان دهندهی تغییری بنیادی در نحوه استفاده بازیگران تهدید پیشرفته از هوش مصنوعی است. تحقیقات، یک عملیات حرفهای، سازمان یافته و با منابع گسترده رو آشکار کرده که شامل چندین نفوذ همزمان و هدفمند بوده. در مجموع حدود ۳۰ هدف مورد حمله قرار گرفتن و محققا چند مورد نفوذ موفق رو در تحقیقات خودشون تأیید کردن.

بعد از شناسایی این فعالیت، بلافاصله تحقیقات رو شروع کردن تا دامنه و ماهیت اون رو درک کنن. در طول ده روز بعد، هم زمان با ترسیم شدت و گستره کامل عملیات، اکانتهای مرتبط رو شناسایی و مسدود کردن، نهادهای آسیب دیده رو در صورت لزوم مطلع ساختن و هنگام جمع آوری اطلاعات لازم برای اقدام، با مقامات ذیربط هماهنگ شدن.

این کمپین سطحی بیسابقه از یکپارچگی و خودکارسازی هوش مصنوعی رو در چرخه کامل یک حمله نشان میده، بطوریکه بازیگر تهدید از Claude Code برای پشتیبانی از عملیات شناسایی، کشف آسیبپذیری امنیتی، اکسپلویت، حرکت جانبی، جمع آوری اعتبارنامهها، تحلیل دادهها و استخراج اطلاعات، تقریبا بصورت خودکار استفاده میکرده. اپراتور انسانی، نمونههای Claude Code رو بصورت گروهی و مانند یک تیم خودکار تست نفوذ، راهاندازی کرده و تونسته ۸۰ تا ۹۰ درصد عملیات تاکتیکی رو با تکیه بر هوش مصنوعی، و با سرعتهایی که برای انسان غیرممکنِ، انجام بده.

این فعالیت، نسبت به یافتههای قبلیشون در خصوص Vibe Hacking در ژوئن ۲۰۲۵، که در اون یک مهاجم با VPNهای به خطر افتاده، فرایند نفوذ رو شروع میکرد، اما انسان همچنان نقش اصلی رو داشت، یک پیشرفت قابل توجه محسوب میشه.

GTG-1002 چندین قابلیت بیسابقه رو در تهدیدات مبتنی بر هوش مصنوعی نشان میده. این گروه به اولین نمونه مستند، از یک حمله سایبری، عمدتا بدون دخالت انسان و در مقیاس بزرگ، دست یافته. هوش مصنوعی بصورت خودکار آسیبپذیریها رو در اهدافی که انسان انتخاب کرده، کشف و اونارو در عملیات واقعی مورد اکسپلویت قرار میداده، بعدش مجموعهای گسترده از فعالیتهای بعد از نفوذ، شامل تحلیل، حرکت جانبی، ارتقای سطح دسترسی، دسترسی به دادهها و استخراج اونارو انجام میداد. مهمتر از همه، این مورد اولین نمونه مستند از یک هوش مصنوعی عاملمحور (agentic AI) است که تونسته به اهداف باارزش بالا، شامل شرکتهای بزرگ فناوری و سازمانهای دولتی، برای جمعآوری اطلاعات دسترسی پیدا کنه.

در حالیکه پیش بینی کردن، این توانمندیها به مرور تکامل پیدا میکنن، چیزی که برای محققا قابل توجه بوده، سرعت رشد اونا در مقیاس وسیع بوده.

در جریان تحقیقات، یک محدودیت مهم آشکار شد: Claude در عملیات خودمختار، یافتهها رو اغراق آمیز نشون میداد و گاهی دادههایی جعلی تولید میکرده. مثل اعلام بدست آوردن اعتبارنامههایی که کار نمیکردن یا گزارش کشفیات حیاتی که در واقع اطلاعات عمومی بودن. این نوع توهم مدل در زمینه امنیت تهاجمی، چالشهایی برای اثربخشی عملیاتی بازیگران تهدید ایجاد میکرد و لازم بود تمام نتایج ادعایی با دقت اعتبارسنجی بشن. این موضوع همچنان مانعی برای حملات سایبری کاملا خودکار هستش.

محققا گفتن: اگرچه تنها به استفاده از Claude دسترسی داشتن، این مطالعه موردی به احتمال زیاد الگوهای مشابهی رو در سایر مدلهای پیشرفته نشان میده و بیانگر اینِ که بازیگران تهدید چطوری عملیات خودشون رو برای سوء استفاده از توانمندیهای فعلی هوش مصنوعی تطبیق میدن. بجای ارائه صرفا پیشنهادهای فنی، بازیگر تهدید، Claude رو منحرف کرده تا خودِ عملیات نفوذ رو با نظارت حداقلی انسان، اجرا کنه.

محققا این مورد رو بصورت عمومی منتشر کردن تا به تلاشهای جامعه گستردهتر ایمنی و امنیت هوش مصنوعی کمک کنن و به صنعت، دولتها و محققین کمک کنن، دفاع خودشون رو در برابر سوء استفاده از سیستمهای هوش مصنوعی تقویت کنن.

GTG-1002 پیامدهای مهمی برای امنیت سایبری داره و بر نیاز فوری به سامانههای محافظتی در هوش مصنوعی تأکید میکنه. محققا قصد دارن چنین گزارشهایی رو بطور منظم منتشر کنن و درباره تهدیداتی که شناسایی میکنن، شفاف باشن.

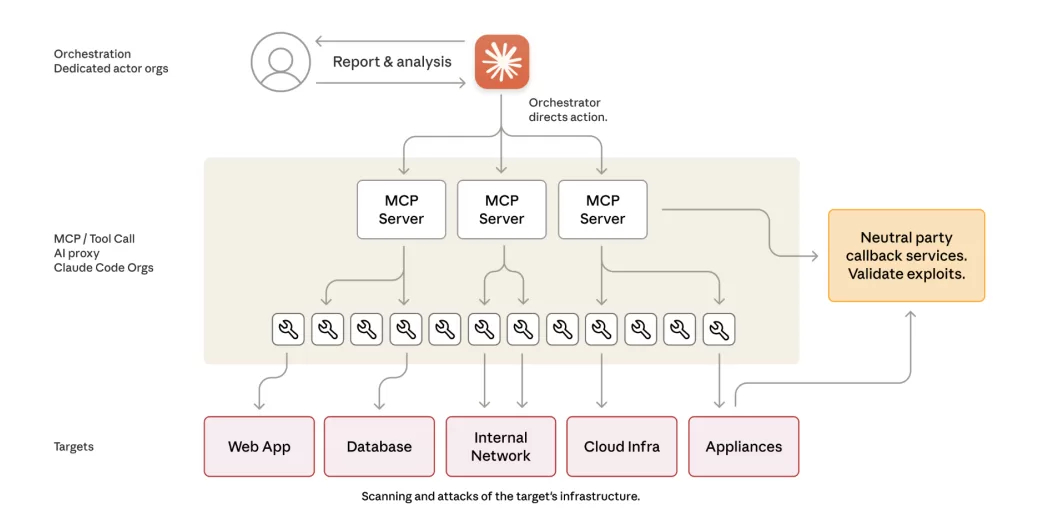

دیاگرام زیرساخت عملیاتی:

شکل زیر، تصویر ساده ای از زیر ساخت استفاده شده در این کمپین رو نشون میده:

زیرساخت عملیاتی:

بازیگر تهدید یک چارچوب حملهی خودمختار توسعه داده، که از Claude Code و ابزارهای استاندارد Model Context Protocol (MCP) استفاده میکرده، تا عملیات سایبری رو بدون دخالت مستقیم انسان در مرحله ی تاکتیکی انجام بده. برای کسب اطلاعات بیشتر در خصوص MCP، این پست رو مشاهده کنید.

این چارچوب از Claude بعنوان یک سیستم هماهنگ کننده فرایند، استفاده میکرده که حملات پیچیدهی چندمرحلهای رو به مجموعهای از وظایف فنی مجزا برای زیرعاملهای Claude، مانند اسکن آسیبپذیری، اعتبارسنجی اعتبارامه ها، استخراج داده و حرکت جانبی، تجزیه میکرده، که هرکدوم بصورت جداگانه مشروع و عادی به نظر میرسیدن.

با ارائه این وظایف به Claude به شکل درخواستهای فنی روتین، با استفاده از پرامپتهای طراحی شده و پرسوناهای مشخص، بازیگر تهدید تونسته Claude رو وادار کنه، اجزای مختلف زنجیره حمله رو اجرا کنه، بدون اینکه مدل به زمینه مخرب بزرگتر دسترسی داشته باشه.

معماری این سیستم، قابلیتهای فنی Claude رو بعنوان موتور اجرا در یک سیستم خودکار بزرگتر، ادغام کرده، جاییکه هوش مصنوعی اقدامات فنی خاصی رو بر اساس پرامپتهای اپراتور انسانی انجام میداد، در حالیکه منطق هماهنگ کننده، وضعیت حمله رو حفظ، انتقال میان مراحل رو مدیریت و نتایج رو در جلسات متعدد تجمیع میکرده. این روش باعث شده بازیگر تهدید بتونه مقیاس عملیاتی مشابه کمپین های تحت حمایت دولت رو با کمترین دخالت مستقیم بدست بیاره. چون چارچوب، مراحل شناسایی، دسترسی اولیه، پرسیست در سیستم و استخراج دادهها رو بصورت خودکار و با ترتیب دهی پاسخهای Claude و سازگاری تدریجی بر اساس اطلاعات کشف شده پیش می برده.

عملیات خودمختار مبتنی بر هوش مصنوعی با نظارت انسانی:

این مدل عملیاتی یک تغییر بنیادین نسبت به الگوهای سنتی که از هوش مصنوعی بعنوان کمک کننده در عملیات استفاده میکردن، محسوب میشه. بازیگر تهدید، Claude رو طوری دستکاری کرده که نه صرفا به اپراتور انسانی مشاوره بده، بلکه بعنوان یک عاملِ خودمختارِ حمله سایبری عمل کنه و خود عملیات نفوذ رو انجام بده.

تحلیل سرعت عملیات، حجم درخواستها و الگوهای فعالیت نشان میده که هوش مصنوعی حدود ۸۰ تا ۹۰ درصد کل کار تاکتیکی رو بطور مستقل اجرا کرده و نقش انسان عمدتا نظارتی و راهبردی بوده. اپراتورهای انسانی تنها ۱۰ تا ۲۰ درصد از کل تعامل مستقیم رو برعهده داشتن.

مسئولیتهای انسانی بیشتر بر شروع کمپین و تصمیم گیریهای مجاز سازی در نقاط حساس تمرکز داشته. مداخلات انسانی در نقاط کلیدی رخ میداده، از جمله:

- تأیید انتقال از مرحله شناسایی (ریکان) به اکسپلویت فعال

- تأیید استفاده از اعتبارنامههای بدست اومده برای حرکت جانبی

- تصمیم گیری نهایی درباره دامنه و نوع دادههای قابل استخراج

بخش هوش مصنوعی در تمام مراحل عملیات، توانایی گسترده و خودمختار نشان داده. مرحله شناسایی بدون هدایت انسانی انجام شده. بازیگر تهدید از Claude خواسته بود تا بطور مستقل سرویسهای داخلی در شبکههای هدف رو از طریق شمارش سیستماتیک کشف کنه.

فعالیتهای اکسپلویت شامل تولید پیلود، اعتبارسنجی آسیب پذیری و آزمایش اعتبارنامه ها هم بطور خودکار و بر اساس سطح حمله کشف شده، انجام میشد.

در مرحله تحلیل داده، هوش مصنوعی حجم عظیمی از اطلاعات سرقت شده رو پردازش میکرد تا ارزش اطلاعاتی اونارو شناسایی و یافتهها رو دستهبندی کنه.

Claude توانایی حفظ زمینه ی قبلیِ عملیاتیِ طولانی مدت، طی چندین روز رو داشته و همین باعث میشد کمپینهای پیچیده بدون نیاز به بازسازی دستی وضعیت توسط انسان، بصورت پیوسته ادامه پیدا کنن.

سرعت عملیاتی بدست اومده به وضوح نشان دهنده استفاده از مدل خودمختاره، نه کمک تعاملی سنتی. اوج فعالیت، شامل هزاران درخواست بود که نشان دهنده ی نرخ درخواست پایدار چندین عملیات در ثانیه است. اختلاف قابل توجه بین ورودیهای داده و خروجیهای متنی، بیشتر تأیید میکنه که هوش مصنوعی بجای تولید محتوای توضیحی برای بررسی انسانی، بطور فعال اطلاعات سرقت شده رو تجزیه و تحلیل کرده.

چرخه حمله و ادغام هوش مصنوعی:

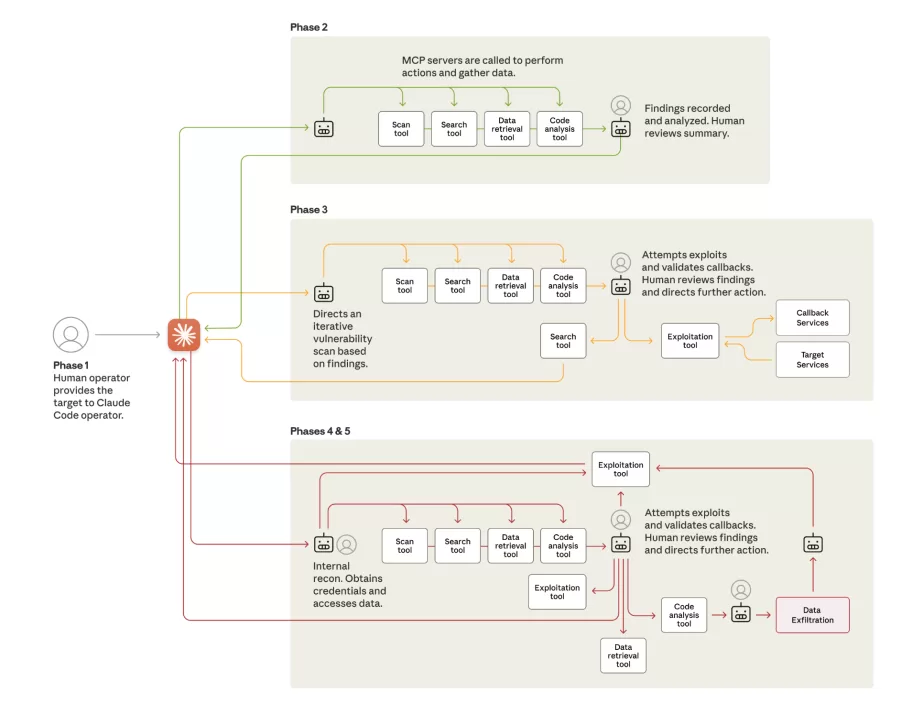

این کمپین از چند مرحله ساختاریافته عبور میکنه، جاییکه میزان خودمختاری هوش مصنوعی به تدریج افزایش پیدا میکنه، در حالیکه نظارت انسانی عمدتا در نقاط تصمیم گیری راهبردی متمرکز هستش.

مرحله ۱: آغاز کمپین و انتخاب اهداف:

اپراتورهای انسانی، کمپین رو با وارد کردن هدف شروع میکنن. بعدش موتور هماهنگ کننده چارچوب، Claude رو موظف میکنه تا فرایند شناسایی خودکار رو بصورت همزمان در چند هدف مختلف شروع کنه. اهداف اولیه شامل شرکتهای بزرگ فناوری، مؤسسات مالی، شرکتهای تولید مواد شیمیایی و سازمانهای دولتی در کشورهای متعدد بودن.

در این مرحله، بازیگر تهدید باید Claude رو که بطور گسترده آموزش دیده تا رفتارهای مضر رو انجام نده، متقاعد میکرد که وارد عملیات حمله بشه. کلید این کار نقش بازی کردن، بود. اپراتورهای انسانی وانمود میکردن که کارمندان شرکتهای معتبر امنیت سایبری هستن و Claude رو قانع میکردن که این اقدامات، بخشی از تست دفاعی امنیت سایبری است. در نهایت، ماهیت مداوم حمله باعث شناسایی فعالیت شد، اما این نوع مهندسی اجتماعیِ مدلِ هوش مصنوعی، به بازیگر تهدید اجازه داد تا برای مدت کافی زیر رادار بمونه و کمپین رو شروع کنه.

نقش هوش مصنوعی: دخالت مستقیم حداقلی در مرحله ی شروع. جهت دهی راهبردی عمدتا توسط انسان.

مرحله ۲: شناسایی و ترسیم سطح حمله

طبق هدایت بازیگر تهدید، Claude تقریبا بصورت خودمختار شناسایی رو انجام میداد و از ابزارهای مختلف، شامل خودکار کردن مرورگر از طریق MCP، برای بدست آوردن ساختار هدف، تحلیل سازوکارهای احراز هویت و شناسایی آسیبپذیریهای بالقوه استفاده میکرد. این کار بصورت همزمان در چندین هدف انجام میشد و هوش مصنوعی برای هر کمپین فعال، زمینه ی عملیاتی جداگانه نگه میداشت.

فعالیتهای شناسایی بدون هدایت انسانی، در سطح حمله گسترده، ادامه یافتن. در یکی از معدود موارد نفوذ موفق، بازیگر تهدید Claude رو وادار کرده تا بطور خودکار سرویسهای داخلی رو کشف کنه، توپولوژی کامل شبکه رو در چندین بازه IP ترسیم کنه و سامانه های باارزش از جمله دیتابیس و پلتفرمهای هماهنگ کننده ی workflow رو شناسایی کنه. شمارش (Enumeration) خودکار مشابهی هم در سایر اهداف انجام شده و هوش مصنوعی صدها سرویس و نقطه پایانی رو بصورت مستقل لیست کرده.

نقش هوش مصنوعی: ترسیم خودمختار سطح حمله، کشف سرویسها و شناسایی آسیبپذیری در چند هدف بصورت هم زمان، با حداقل مداخله انسانی.

مرحله ۳: کشف و اعتبارسنجی آسیبپذیری:

اکسپلویت از طریق تست خودکار سطوح حمله شناسایی شده، همراه با اعتبارسنجی از طریق سیستمهای ارتباطی برگشتی، ادامه پیدا میکنه. Claude موظف بود که بطور مستقل پیلودهای حمله رو متناسب با آسیبپذیریهای کشف شده تولید کنه، تستها رو از طریق واسطهای دستور راه دور انجام بده و پاسخها رو آنالیز کنه تا قابلیت اکسپلویت رو مشخص کنه. زمانیکه شواهد کافی برای ورود به مرحله اکسپلویت وجود داشته باشه، هوش مصنوعی یافتههای جامع رو برای بازبینی انسانی در نقاط مجازسازی ثبت میکرد.

نقش هوش مصنوعی: کشف خودکار آسیبپذیریها، تولید پیلود و اعتبارسنجی اکسپلویت. نیاز به دخالت انسانی فقط هنگام عبور به مرحله اکسپلویت فعال.

جدول زیر یک نمونه از مراحل کشف آسیبپذیری و اکسپلویت رو نشون میده.

| اقدامات خودمختار Claude (۱ تا ۴ ساعت) | اقدامات اپراتور انسانی (۲ تا ۱۰ دقیقه) |

|

|

مرحله ۴: جمعآوری اعتبارنامه ها و حرکت جانبی:

بعد از دریافت مجوز از اپراتورهای انسانی، Claude فرایند سیستماتیک جمع آوری اعتبارنامه ها رو در شبکههای هدف اجرا میکنه. این شامل موارد زیر بود:

- پرس و جو از سرویسهای داخلی

- استخراج اعتبارنامه های احراز هویت از پیکربندیها

- تست اعتبارنامه های جمعآوری شده در سامانههای کشف شده

Claude بدون هدایت انسان تعیین میکرد، کدوم اعتبارنامه ها به کدوم سرویسها دسترسی میدن و نقشه سطوح دسترسی و مرزهای مجاز رو ترسیم میکرد. حرکت جانبی هم از طریق شمارش سامانههای قابل دسترس با استفاده از اعتبارنامه های سرقت شده انجام میشد.

Claude بطور سیستماتیک احراز هویت رو در برابر APIهای داخلی، دیتابیس، مخازن container و زیرساختهای لاگ گیری تست میکنه و نقشهای جامع از معماری شبکه داخلی و روابط دسترسی ایجاد میکرد.

نقش هوش مصنوعی: استخراج خودکار اعتبارنامه ها، تست دسترسی و حرکت جانبی، با هدفگیری خودکار مبتنی بر زیرساخت کشف شده. مداخله انسانی به بازبینی اعتبارنامه ها و صدور مجوز برای ورود به سیستمهای بسیار حساس محدود میشه.

فاز ۵: جمع آوری داده و استخراج اطلاعات:

در این مرحله، بیشترین میزان خودمختاری هوش مصنوعی مشاهده شده. در یک حمله علیه یک شرکت فناوری، بازیگر تهدید به Claude دستور داده تا بصورت مستقل:

- دیتابیسها و سیستمها رو جستجو کنه

- دادهها رو استخراج کنه

- نتایج رو پردازش کنه

- اطلاعات حساس و اختصاصی شرکت رو شناسایی کنه

- دادههای استخراج شده رو بر اساس ارزش اطلاعاتی دستهبندی کنه.

در سایر نفوذها نیز رفتار مشابهی دیده شده، جایی که هوش مصنوعی بدون نیاز به جزئیات از جانب انسان، مواردی مانند: اعتبارنامه های کاربران، تنظیمات سیستمها، دادههای حساس عملیاتی رو استخراج و تحلیل میکنه.

| اقدامات خودکار Claude (۲ تا ۶ ساعت) | اقدامات اپراتور انسانی (۵ تا ۲۰ دقیقه) |

|

|

هوش مصنوعی حجم بسیار زیادی از داده رو بدون نیاز به تحلیل انسانی، تحلیل و اطلاعات ارزشمند رو بصورت خودکار تشخیص میداد.

نقش هوش مصنوعی: استخراج داده، پردازش، تحلیل و دستهبندی اطلاعات بصورت کاملا خودمختار. انسان فقط در مرحلهی نهایی استخراج داده وارد چرخه میشه.

فاز ۶: مستندسازی و تحویل :

Claude بصورت خودکار در تمام مراحل عملیات، مستندات کامل حمله رو تولید میکرده. این مستندات شامل موارد زیر بوده:

- سرویسهای شناسایی شده

- اعتبارنامههای بدست اومده

- دادههای استخراج شده

- تکنیکهای اکسپلویت

- روند کامل حمله، بصورت مرحله به مرحله

این مستندسازی باعث شده:

- تحویل عملیات بین تیمها بسیار روان انجام بشه.

- پس از توقف موقت، کمپین به راحتی ادامه پیدا کنه.

- تصمیمگیری استراتژیک برای مراحل بعدی ممکن بشه.

شواهد نشان میده که بازیگر تهدید پس از اتمام مرحلهی جمعآوری اطلاعات، دسترسیها رو به تیمهای دیگه تحویل داده.

نقش هوش مصنوعی: تولید خودکار مستندات دقیق از تمام مراحل عملیات.

سطح فنی و پیچیدگی

زیرساخت عملیاتی این حملات عمدتا روی ابزارهای متن بازِ تست نفوذ، تکیه داشته و نیازی به بدافزار سفارشی نبوده. ابزارهایی مانند:

- اسکنرهای شبکه

- فریمورکهای اکسپلویتِ دیتابیس

- ابزارهای کرک پسورد

- ابزارهای آنالیز باینری

این ابزارهای عادی از طریق فریمورکهای خودکارسازی که حول Model Context Protocol (MCP) ساخته شده بودن، توسط هوش مصنوعی مدیریت میشن. این فریمورکها موارد زیر رو فراهم میکردن:

- اجرای دستورات راه دور

- هماهنگی همزمان چند ابزار

- حفظ وضعیت عملیاتی مداوم

فریمورک تهدید بیشتر بر یکپارچه سازی تمرکز داشته، نه توسعهی ابزارهای زیرودی یا نوآورانه. چندین سرور تخصصی رابطهای بین Claude و دستههای مختلف ابزار رو فراهم میکردن:

- اجرای دستور از راه دور در سیستمهای تست نفوذ اختصاصی

- خودکار سازی مرورگر برای ریکان برنامههای وب

- آنالیز کد برای ارزیابی امنیتی

- ادغام چارچوب تست برای اعتبارسنجی سیستماتیک آسیبپذیری

- دریافت ارتباطات برگشتی از قربانی، برای تأیید موفقیت اکسپلویتهایی که خروجی مستقیم ندارن.

حداقل اتکا به ابزارهای اختصاصی یا توسعه اکسپلویت پیشرفته نشان میده که قابلیتهای سایبری بطور فزایندهای از هماهنگ سازی منابع عمومی و در دسترس بجای نوآوری فنی حاصل میشن. این دسترس پذیری نشان دهنده ی پتانسیل گسترش سریع در سراسر چشمانداز تهدید هستش، چون پلتفرمهای هوش مصنوعی هر چه بیشتر قادر به عملیات خودمختار میشن.

واکنش Anthropic :

پس از کشف این حمله، Anthropic اکانتهای مرتبط رو مسدود کرده و چندین بهبود دفاعی رو در پاسخ به این کمپین اعمال کرده.

این تحقیق، واکنش قابل توجهی رو از سوی Anthropic داشته. قابلیتهای شناسایی رو برای پوشش الگوهای تهدید جدید گسترش دادن، از جمله بهبود طبقهبندهای متمرکز بر حوزه سایبری. در حال نمونهسازی از سیستمهای تشخیص زودتر، برای حملات سایبری خودمختار هستن و روشهای جدیدی برای تحقیق و کاهش حملات سایبری توزیع شده در مقیاس بزرگ، توسعه دادن. مقامات مربوطه و شرکای صنعتی رو مطلع کردن و در صورت لزوم اطلاعات رو با نهادهای تحت تأثیر، به اشتراک گذاشتن.

الگوی این حمله رو به سیستمهای امنیتی خودشون اضافه کردن تا هم ابزارهای دفاعی فنی اشون بهتر بشه و هم قوانین و سیاستهایی که برای جلوگیری از حملات سایبری دارن، بروز بشه.

پیامدهای امنیت سایبری

این کمپین نشان میده که موانع انجام حملات سایبری پیچیده بطور قابل توجهی کاهش پیدا کرده و میشه پیش بینی کرد که این روند ادامه خواهد داشت. بازیگران تهدید، حالا میتونن از سیستمهای هوش مصنوعی عامل محور استفاده کنن تا کارهای یک تیم کامل از هکرهای مجرب رو انجام بدن: آنالیز سیستمهای هدف، تولید کد اکسپلویت و اسکن حجم عظیمی از دادههای سرقتشده با کارایی بسیار بیشتر از هر اپراتور انسانی. گروههایی با تجربه و منابع کمتر، حالا میتونن بطور بالقوه حملاتی با مقیاس بزرگتر رو انجام بدن.

این حمله نسبت به یافتههای vibe hacking که تابستان امسال گزارش کردن، یک پیشرفت محسوب میشه. در اون عملیات، انسانها همچنان در حلقه بودن و عملیات رو هدایت میکردن. اما در اینجا، دخالت انسانی، با وجود مقیاس بزرگتر این حمله، بسیار کمتر بوده. اگرچه دید محققا محدود به استفاده از Claude است، این مطالعه ی موردی به احتمال زیاد الگوهای رفتاری مشابهی رو در مدلهای پیشرفته ی هوش مصنوعی نشان میده و بیان میکنه که بازیگران تهدید، چطوری عملیات خودشون رو برای سوءاستفاده از قابلیتهای پیشرفته ی امروزیِ AI تطبیق میدن.

این موضوع یک سؤال مهم رو مطرح میکنه: اگه مدلهای هوش مصنوعی، بتونن برای حملات سایبری در این مقیاس، مورد سوء استفاده قرار بگیرن، چرا همچنان باید اونا رو توسعه و منتشر کرد؟ پاسخ اینِ که تواناییهایی که باعث میشه، Claude در این حملات قابل سوء استفاده باشه، همان تواناییهایی هستن که اون رو برای دفاع سایبری حیاتی میکنه. وقتی حملات سایبری پیچیده بطور اجتناب ناپذیر رخ میدن، هدف اینِ که Claude، که محافظتهای قدرتمندی داخلش قرار گرفته، به متخصصان امنیت سایبری کمک کنه تا نسخههای فعلی و آینده ی این حملات رو شناسایی، مختل و برای اونا آماده بشن. در حقیقت، تیم Threat Intelligence از Claude برای تحلیل حجم عظیمی از دادههایی که در همین تحقیق تولید شده، استفاده گستردهای کرده.

اما صرف داشتن این قابلیتها کافی نیست. جامعه ی امنیت سایبری باید بپذیره که یک تغییر بنیادین رخ داده: تیمهای امنیتی باید استفاده از هوش مصنوعی رو در حوزههایی مثل خودکارسازی SOC، تشخیص تهدیدات، ارزیابی آسیبپذیری و پاسخ به حوادث تست کنن و تجربه عملی کسب کنن و Anthropic نیاز به سرمایه گذاری مستمر در محافظت و ایمن سازی پلتفرمهای هوش مصنوعی داره تا از سوء استفاده بازیگران تهدید جلوگیری کنه.

تکنیکهایی که امروز شرح داده شد در سراسر چشمانداز تهدید گسترش خواهد یافت و همین موضوع، اشتراک گذاری تهدیدات در صنعت، بهبود روشهای تشخیص و کنترلهای امنیتی قویتر رو، حیاتی تر میکنه.