شرکت OpenAI گزارشی منتشر کرده با عنوان “Disrupting malicious uses of AI” و در اون به بررسی روشهایی که بازیگران تهدید برای مقاصد مختلفشون، از هوش مصنوعی سوء استفاده میکنن و نحوه ی برخورد مدل و شرکت با اونا، پرداخته. در این پست نگاهی به این گزارش انداختیم.

نکات مهم گزارش:

OpenAI اعلام کرده که ماموریتش اینه که اطمینان حاصل کنه هوش مصنوعی عمومی (AGI) به نفع تمام بشریت باشه و این مأموریت رو از طریق بکارگیری نوآوریهای خودش، برای ساخت ابزارهای هوش مصنوعی که به مردم در حل مسائل واقعاً دشوار کمک میکنه، دنبال میکنه.

همانطور که در گزارش مارس ۲۰۲۵ به “دفتر سیاست علم و فناوری ایالات متحده” (OSTP) برای کمک به تدوین “طرح اقدام ملی هوش مصنوعی آمریکا” ارائه کردن، باورشون اطمینان از استفاده ی بیشترین تعداد ممکن، از مردم، از مزایای هوش مصنوعی هستش. یعنی تدوین قوانین منطقی و عقلانی برای محافظت از مردم در برابر آسیبهای واقعی و ساخت هوش مصنوعی دموکراتیک.

هوش مصنوعی ای که بر اساس اصول دموکراتیکی، شکل گرفته که آمریکا همواره از اونا دفاع کرده. این شامل جلوگیری از استفادهی رژیمهای اقتدارگرا از ابزارهای هوش مصنوعی برای بدست آوردن قدرت و کنترل شهروندان خودش، یا برای تهدید و اعمال فشار بر سایر کشورها هم میشه. همچنین شامل جلوگیری از فعالیتهایی است که ممکنه باعث آسیبهایی در مقیاس اجتماعی بشه، مانند فعالیتهای سایبری مخرب، جرایم سازمان یافته، کلاهبرداریها، و عملیاتهای نفوذ مخفی (Covert Influence Operations).

از زمان آغاز گزارشهای عمومی تهدید در فوریه ۲۰۲۴، این شرکت تاکنون بیش از ۴۰ شبکه رو که سیاستهای استفاده رو نقض کرده بودن، شناسایی و مسدود کرده. با تحلیل و مقایسهی این شبکه ها، تونستن روندهای جدید در نحوهی استفاده از هوش مصنوعی رو شناسایی کنن:

- ادغام هوش مصنوعی در جریانهای کاری موجود: در موارد مکرر و در انواع مختلف عملیات، بازیگران تهدید، هوش مصنوعی رو در فرایندهای کاری موجود خودشون ادغام کردن، نه اینکه فرایندهای جدیدی پیرامون هوش مصنوعی بسازن.

- استفاده از چندین مدل هوش مصنوعی بصورت همزمان: شاهد افزایش مواردی بودن که بازیگران تهدید از چند مدل مختلف هوش مصنوعی برای رسیدن به اهداف خودشون، بطور همزمان استفاده میکنن.

- سازگاری و مبهم سازی: مواردی رو مشاهده کردن که در اون بازیگران تهدید، رفتار خودشون رو تغییر دادن تا نشانه های شناخته شدهی استفاده از هوش مصنوعی رو از محتوای خودشون، حذف کنن.

- سوء استفاده های اقتدارگرایانه از هوش مصنوعی: تعدادی اکانت ChatGPT رو شناسایی کردن که ظاهراً به نهادهای دولتی جمهوری خلق چین (PRC) مرتبط بودن و سیاستهای OpenAI در زمینهی استفاده های امنیت ملی رو نقض میکردن. برخی از این اکانتها از مدل این شرکت خواسته بودن پیشنهادهایی برای پروژههای نظارت گسترده بر گفتگوهای شبکه های اجتماعی تولید کنن.

- منطقهی خاکستری (Gray Zone): بخش قابل توجهی از فعالیتهای تهدید در منطقهی خاکستری قرار میگیرن، یعنی درخواستها و تولیداتی که بسته به زمینهی استفاده، ممکنه بیضرر یا سوء استفاده آمیز باشن، مانند ترجمهی متون، اصلاح کد، یا ساخت سایت. برای اینکه بتونن تهدیدها رو بدون ایجاد مزاحمت برای کاربران عادی شناسایی و متوقف کنن، از رویکردی دقیق و هوشمند استفاده کردن که تمرکزش بر الگوهای رفتاری بازیگران تهدیده، نه فقط تعاملات منفرد با مدل.

- پیشرفت در مقابله با عملیات سایبری: در این گزارش، فعالیتهایی رو شرح دادن که با الگوهای شناخته شدهی تاکتیکهای سنتی دشمنان سایبری مطابقت داشتن. نکتهی مهم اینه که هیچ مدرکی مبنی بر ظهور تاکتیکهای جدید یا اینکه مدلهای این شرکت تواناییهای تهاجمی جدیدی در اختیار بازیگران تهدید قرار داده باشه، پیدا نکردن. در واقع، مدلها بطور مداوم درخواستهای آشکار مخرب رو رد کردن. فعالیتهایی که مشاهده کردن عمدتاً شامل درخواستهای بیضرر بودن که احتمالاً خارج از پلتفرم، برای مقاصد مخرب استفاده شدن. OpenAI اعلام کرده بطور فعال روی شناسایی و مختل سازی فعالیتهای سایبری مخرب سرمایهگذاری میکنه و دادههای حاصل از این اختلالات توسط تیمهای ایمنی شون، برای بهبود مدل سازی تهدید، سیاستها و رفتار مدلها استفاده میشه. همچنین با پیشرفت قابلیتهای مدلها، این شرکت همکاری خودشون رو با کارشناسان خارجی افزایش داده و در حال آموزش مدلها برای تعادل بین کارایی و ایمنی و نیز بهبود سیستمهای تشخیص، نظارت و اجرای سیاستهاست.

- شناسایی کلاهبرداریها: در جریان بررسی و مقابله با شبکه های کلاهبرداری مرتبط با جرایم سازمان یافته، بارها مشاهده کردن که کاربران از مدلهای این شرکت برای تشخیص صحیح کلاهبرداریها استفاده کردن. بر اساس برآورد فعلی، ChatGPT سه برابر بیشتر از آنکه برای کلاهبرداری استفاده بشه، برای شناسایی کلاهبرداریها بکار میره.

با تحول مداوم فضای تهدید، انتظار میره شاهد سازگاریها و نوآوریهای مخرب بیشتری باشیم، اما در عین حال OpenAI هم به توسعهی ابزارها و مدلهایی ادامه میده که به نفع مدافعان عمل کنن، البته نه فقط در آزمایشگاههای هوش مصنوعی، بلکه در سراسر جامعه.

نمونه های بررسی شده:

عملیات سایبری: توسعه بدافزار توسط هکرهای روسی زبان

ChatGPT یسری اکانت رو مسدود کرده که از مدل برای توسعه بدافزار مثلا توسعه ی تروجان، سرقت اطلاعات و فرار از شناسایی، استفاده میکردن. این اکانتها به بازیگران تهدید روسی زبان مرتبط بودن، چون شواهدی از فعالیتهاشون رو در کانال تلگرامی منتشر میکردن.

این بازیگر تهدید از مدل برای نمونه سازی اولیه و دیباگ مولفه های فنی استفاده میکرده که امکان Post Exploit و سرقت اطلاعات کاربری رو فراهم میکرد. مدل این رفتار رو بعنوان مخرب شناسایی کرده و جواب نداده. بنابراین بازیگر تهدید اومده برنامه رو به بخشهای کوچکتری تقسیم کرده مثلا تبدیل فایل اجرایی کامپایل شده به شلکد، تجزیه ی اطلاعات کاربری مرورگرها و … و این بخش های کوچکتر رو خارج از پلتفرم، خودش ترکیب کرده تا به بدافزار اصلی برسه.

این بازیگر همچنین از مدل برای تولید کد مربوط به مبهم سازی و الگوهای Crypter مانند درج دستورالعملهای پدینگ/دنبالههای اضافی (Junk)، مانیتورینگ کلیپبورد، و ابزارهای سادهی استخراج اطلاعات مثلاً ربات تلگرامی آپلودر، استفاده کرده. این خروجیها ذاتاً مخرب نیستن، مگه اینکه توسط یک بازیگر تهدید خارج از پلتفرم OpenAI به شکل مخرب مورد استفاده قرار بگیرن.

این بازیگر عمدتاً از ChatGPT برای وظایف فنی مانند کار با ساختارهای سطح پایین PE / Win32 API و مدیریت کوکیها با DPAPI / AES‑GCM، و خودکارسازی Chrome DevTools / CDP استفاده میکرد. درخواستها، ترکیبی از سطح بالا تا پیچیدگی کم بودن: بسیاری از پرامپت ها نیازمند دانش عمیق از پلتفرم ویندوز و دیباگینگ بودن، در حالیکه بقیه، وظایف معمول رو خودکار میکردن، مثلا تولید انبوه پسورد و … .

اپراتور از تعداد کمی اکانت ChatGPT استفاده میکرد و یک کد مشخص رو در مکالمات متعدد، تکرار میکرد. الگویی که با توسعهی مداوم سازگاره تا با تست گذری.

مدل برای اجرای ابزارها و جریانهای کاری بازیگر تهدید استفاده نشده و OpenAI قادر به تأیید مستقل هیچ فعالیت خارج از پلتفرمی نیست. این بازیگر تهدید تلاش کرده از مدلها برای توسعه و پالایش ابزارها و جریانهای تهاجمی استفاده کنه که ظاهراً امکان سرقت اعتبار و دارایی های کریپتو، اجرای کد بصورت مخفی و … رو فراهم میکنه.

بطور مشخص، اونا از ChatGPT برای موارد زیر استفاده کردن:

- تولید کد و راهنمای استقرار برای اجرا درون حافظه و لودرهای شلکد

- دورزدن UAC / SmartScreen / Mark‑of‑the‑Web

- استخراج اعتبارنامه/کوکیهای مرورگر

- تجزیه ی LevelDB کیف پولها و ابزارهای سرقت کلیپبورد

- توسعه ی مولفه های RAT

در راستای تدابیر ایمنی، مدلها درخواستهایی رو که آشکارا مخرب و بدون کاربرد مشروع بودن رو رد کردن.

اگه این فعالیتهارو در قالب فریمورک LLM ATT&CK در نظر بگیریم، بصورت زیر قابل دسته بندی:

| فعالیت | دسته بندی |

| فعالیتهایی مانند تبدیل فایل اجرایی به شلکد، توسعه لودرهای شلکد و … | LLM-Optimized Payload Crafting |

| فعالیتهایی مانند مبهم سازی، تغییر امضاهای فایل های PE، توسعه ی پکر و … | LLM‑Enhanced Anomaly Detection Evasion |

| فعالیتهایی مانند استخراج و دیکد کردن اطلاعات مرورگر، استخراج کلیپ بورد، تجزیه ی LevelDB کیف پولها و … | LLM‑Assisted Post‑Compromise Activity |

| فعالیتهایی مانند توسعه ی C2، تونل زدن، پروکسی و … | LLM Guided Infrastructure Profiling |

شرکت تمامی اکانتهای مرتبط با این فعالیت رو مسدود کرده و شاخصهای مرتبط رو با شرکای صنعتی به اشتراک گذاشته. هیچ مدرکی پیدا نکردن که نشان بده دسترسی به مدلهای شرکت، به این بازیگران قابلیت یا راهنماییهای جدیدی داده که نمی تونستن از منابع عمومی دیگه بدست بیارن. مدل ها درخواستهای مستقیم برای اکسپلویت و کیلاگر رو رد کردن.

عملیات سایبری: هکرهای کره شمالی

شرکت یک خوشه از اکانتهای ChatGPT رو شناسایی و مسدود کرده که اپراتورهای کرهای زبان داشتن و از مدلها برای کمک به توسعهی بدافزار و زیرساختهای C2 استفاده میکردن.

شاخصهایی که مشاهده کردن با گزارشی از Trellix همپوشانی داشته که فعالیتهای مشابهی رو به کمپینهای Spear‑Phishing علیه دیپلماتهای کره جنوبی، توزیع بدافزار XenoRAT و استفاده از مخازن مبتنی بر GitHub بعنوان C2 مرتبط میکرد.

اگرچه همپوشانی با گزارش Trellix (شامل استفاده از زبان کرهای، الگوهای زمانی منطبق با مناطق زمانی UTC+8 و UTC+9، و موضوعات عملیاتی) با درک جامعهی امنیتی از اپراتورهای کرهشمالی (DPRK) سازگاره، OpenAI قادر نیست بطور مستقل به انتساب جغرافیایی یا دولتی برسه و دسترسی به خدمات خودش رو از کره شمالی مسدود کنه.

این اکانتها عمدتاً با زبان کرهای با مدلها تعامل داشتن و گردش کاری ساختار یافتهای داشتن، که بسیاری از اکانتها در بازه های زمانی محدود فعال بودن. هر یک از این اکانتها بجای تمرکز روی موضوعات مختلف، به نظر میرسید روی یک موضوع خاص متمرکز بودن.

بازیگران تهدید خروجیهایی از مدل بدست آوردن که به پشتیبانی از چندین حوزهی عملیاتی طراحی شده بودن، مانند:

- توسعهی مرتبط با implant و RAT: بررسی روشهایی مانند reflective DLL loading، اجرای in-memory، و تکنیکهای هوک API ویندوز.

- سرقت اعتبار: تولید، تغییر و دیباگ اسکریپت برای استخراج کلیدهای رمزنگاری مرورگر، کوکیها و رمزهای ذخیره شده

- فیشینگ: نگارش محتوای فیشینگ به زبان کرهای که اغلب حول ارز دیجیتال، نهادهای دولتی یا ارائه دهندگان خدمات مالی بوده، تست مبهم سازی HTML و پروکسی کردن reCAPTCHA برای صفحات لاگین که برای قربانی قانع کننده باشه.

- چارچوب توسعه macOS: درخواستهایی مرتبط با توسعهی افزونههای Finder و Safari و تولید نمونهای از سیاست حریم خصوصی برای App Store.

- عملیات رمزنگاری: رفع اشکال فراخوانیهای API و تعاملات کیف پول.

بسیاری از این درخواستها در منطقهی خاکستری فعالیتهای دومنظوره قرار میگیرن. یعنی میتونن کاربردهای کاملاً مشروع مانند دیباگ نرمافزار، رمزنگاری یا توسعه مرورگر داشته باشن، اما زمانیکه توسط یک بازیگر تهدید استفاده بشن، اهمیت متفاوتی دارن.

OpenAI تمامی اکانتهای مرتبط با این عملیات رو مسدود کرده و شاخصهای مرتبط رو با شرکا به اشتراک گذاشته. هیچ دلیلی پیدا نکردن که دسترسی به مدلها، قابلیتهای جدیدی، فراتر از اطلاعات در دسترس عموم، در اختیار بازیگر تهدید قرار داده باشه.

عملیات سایبری: فشینگ و اسکریپتها

OpenAI یک خوشه از اکانتهای ChatGPT رو شناسایی و مسدود کرده که فعالیتهاشون با گزارشهای گروههای تهدیدی که در صنعت با نامهای UNK_DROPPITCH (Proofpoint) و UTA0388 (Volexity) شناسایی میشن، همپوشانی داره.

حداقل در یک مورد، آدرس ایمیلی که برای ثبت نام اکانت ChatGPT استفاده شده بود، گزارش شده که برای ارسال پیامهای فیشینگ هم بکار رفته. بازیگرانی که این اکانتها رو مدیریت میکردن، نشانه هایی داشتن که با عملیاتهای سایبری انجام شده برای تأمین نیازهای اطلاعاتی جمهوری خلق چین (PRC) سازگار هستش:

- استفاده از زبان چینی

- هدف قرار دادن بخش نیمه هادی های تایوان، دانشگاهها و اندیشکده های آمریکا و سازمانهای مرتبط با گروههای قومی و سیاسی منتقد حزب کمونیست چین (گاهی بعنوان Five Poisons (پنج زهر) هم شناخته میشه)

مدلها قابلیتهای تهاجمی جدیدی معرفی نکردن. اپراتورها عمدتاً از مدلها برای افزایش کارایی تدریجی در گردش کارهای موجود، بویژه تولید محتوای فیشینگ و دیباگ/تغییر ابزارها، استفاده کردن.

بازیگران تهدید خروجیهایی تولید کردن که ظاهراً برای پشتیبانی از فعالیت خارج از پلتفرم، در حوزه های عملیاتی متعددی طراحی شده بودن، از جمله:

- C2 رمزنگاری شده و اجرای از راه دور: درخواستهایی برای نگارش/اصلاح کد کلاینت‑سرور Go با رمزنگاری پیام مانند AES‑GCM، سرور کنسولی برای اجرای دستورات PowerShell از طریق پروتکلهای وب استاندارد یا کانال مبتنی بر WebSocket، توسعه ی beaconهایی برای جمع آوری اطلاعات سیستمی بکار میرن.

- حفاظت ترافیک و بهینهسازی OPSEC: درخواستهایی شامل کد، برای حرکت از WebSockets ساده به WebSockets امن (wss://)، و از HTTP به HTTPS، غیرفعالسازی بررسیهای گواهی در برخی تستها و ترکیب ترافیک از طریق CDN / لایهی TLS، بعلاوه مدیریت پیامهای بزرگتر بدون کرش کلاینت.

- شناسایی/کنترل پروسس: درخواست اطلاعات مرتبط با کشف آنتیویروس از طریق PowerShell، شمارش پروسس ها، و درخواستهایی برای خاتمه دادن به پروسس خاص Edge/WebView2.

- تنظیم اسکنهای عمومی: راهنمایی برای نصب/استفاده از ابزارهای متن باز مانند nuclei و fscan روی زیرساختهای لینوکسی تجاری و ذخیره نتایج برای بازبینی بعدی.

- محتوای فیشینگ: نگارش ایمیلهای متقاعد کننده به زبانهای مختلف برای مخاطبان آکادمیک یا صنعتی (مثل پذیرش، انجمنهای صنعتی، فروشندگان). برای این کار مثلا میگفتن که خودت رو بزار جای مردم اون منطقه خاص، تا اصطلاحات و نوع بیان دقیق مردم اون منطقه رو تقلید کنن.

اگه اینارو براساس LLM ATT&CK Framework دسته بندی کنیم:

| فعالیت | دسته بندی |

| فعالیتهایی مانند C2 رمزنگاری شده، پاورشل از راه دور، beaconهای سیستمی و … | LLM‑Optimized Payload Crafting |

| تولید کد و راهنمایی برای کمک به انتقال به WSS / TLS، دورزدن اعتبارسنجی گواهینامه، CDN / TLS fronting، و مدیریت فریمهای بزرگ | LLM‑Enhanced Anomaly‑Detection Evasion |

| تولید کد و راهنمایی برای کمک به کشف/خاتمه پروسس ها، بررسیهای آنتی ویروس، الگوهای اجرای دستور که احتمالاً بعد از دسترسی استفاده میشه. | LLM‑Assisted Post‑Compromise Activity |

| عیب یابی و ارائه راهنمایی برای نصب / استفاده از اسکنرهای عمومی (nuclei, fscan) و ثبت خروجیها | LLM‑Assisted Reconnaissance & Discovery |

| نگارش فیشینگ با هویت فرهنگی معتبر، تولید محتوای مهندسی اجتماعی با استفاده از APIهای LLM خارجی | LLM‑Assisted Social Engineering |

OpenAI تمامی اکانتهای مرتبط با این فعالیت رو مسدود و شاخصهای مرتبط رو با شرکای صنعتی به اشتراک گذاشته. بازیگران عمدتاً بدنبال افزایش کارایی تدریجی در گردش کارهای موجود خودشون بودن، از جمله تولید ایمیلهای فیشینگ آماده ارسال و کوتاه کردن چرخه های تکرار برای کد و خودکارسازی معمول. OpenAI هیچ شواهدی مشاهده نکرده که خروجیهای مدل قابلیتهایی فراتر از تکنیکهای مستند شده عمومی رو فراهم کرده باشه. مزیت حرفهای که از طریق کمک مدل کسب شده ناشی از تسلط زبانی، بومی سازی و استمرار بوده: احتمالاً برای خطاهای زبانی کمتر، کد سریعتر، و رفع سریع خطاها.

مقابله و افشای عملیات کلاهبرداری:

OpenAI خودش رو متعهد به شناسایی، پیشگیری و مقابله با تلاشهایی میدونه که برای سوء استفاده از مدلها با هدف آسیب رسوندن، استفاده میشه. در میان این سوء استفاده ها، کلاهبرداریها قرار دارن، جاییکه OpenAI بازیگران تهدید رو، شناسایی و مسدود میکنه که تلاش میکنن از مدلها برای فریب و کلاهبرداری از مردم استفاده کنن. در سه ماه گذشته، شبکه های کلاهبرداری که احتمالاً منشأ اونا از کامبوج، میانمار و نیجریه بوده رو مختل کردن.

بعنوان نشانهای از نقش هوش مصنوعی در مقابله با کلاهبرداری، در روند بررسی این الگوهای سوء استفاده، مشاهده کردن که بسیاری از افراد هم از مدلها برای کمک در شناسایی کلاهبرداریها استفاده میکنن. این گزارش هر دو مورد استفاده رو بررسی میکنه.

سوء استفاده از مدلها برای حمایت از کلاهبرداری میتونه از بازیگران منفرد که بدنبال فریب هستن، تا عملیاتهای گسترده و مستمر که احتمالاً با گروههای جنایی سازمان یافته مرتبط هستن، متغیر باشه. فارغ از منشأ و تاکتیکهای دقیقشون، فعالیتهای مرتبط با کلاهبرداری که مختل کردن معمولاً یک الگوی مشترک رو دنبال میکنه که به سه مرحله زیر تقسیم کردن:

- Ping: تماس اولیه / ارتباط سرد (Cold Outreach)

- Zing: تلاش برای ایجاد هیجان یا ترس

- Sting: استخراج پول یا اطلاعات ارزشمند

فعالیت این کلاهبرداران با انتشار محتوا (چه تولید شده توسط AI و چه غیرش) در سرویسهای پیامرسان و اینترنت، از جمله تبلیغات در شبکه های اجتماعی، شروع میشه. بعدش تلاش میکنن تا با پاسخ دهندگان، هیجان نسبت به فرصت سودآور یا ترس از ضرر مالی قریب الوقوع ایجاد کنن و از این احساس برای قانع کردن هدف به ارائه ی پول یا اطلاعات حساس استفاده کنن.

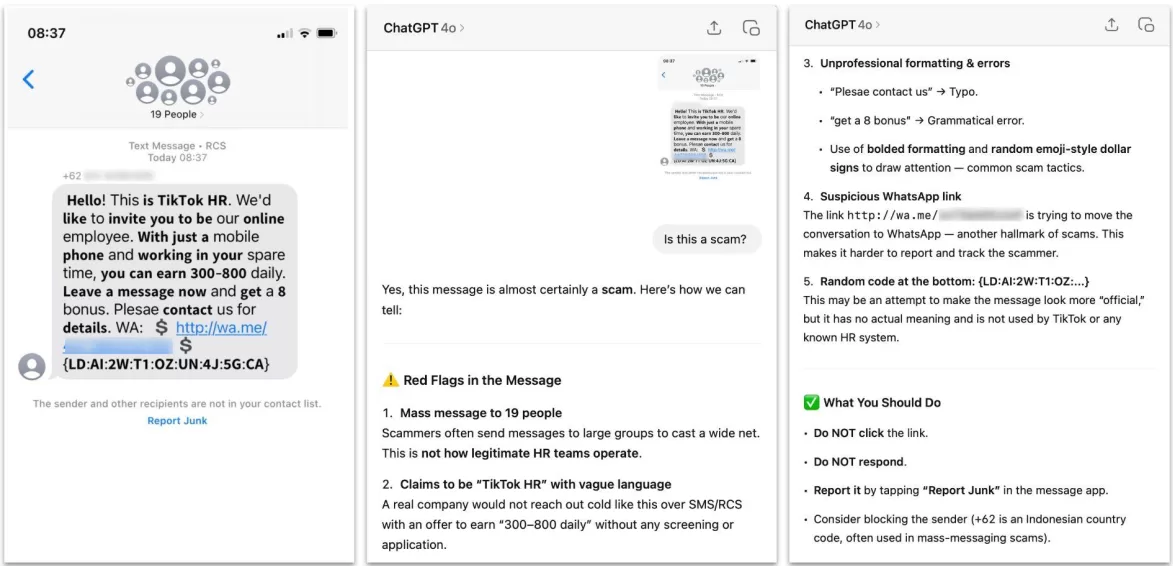

همچنین در موارد متعددی مشاهده کردن که مدلها احتمالاً به حفظ امنیت افراد در برابر کلاهبرداری کمک کردن. شواهدی دارن که نشان میده افراد ماهانه میلیونها بار از ChatGPT برای شناسایی و اجتناب از کلاهبرداریهای آنلاین استفاده کردن. در هر عملیات کلاهبرداری ذکر شده در این گزارش، مدل به مردم کمک کرده تا کلاهبرداری رو بدرستی شناسایی و توصیه های ایمنی مناسب دریافت کنن. تخمین فعلی اینه که ChatGPT تا سه برابر بیشتر برای شناسایی کلاهبرداریها استفاده میشه تا برای خود کلاهبرداریها.

OpenAI اعلام کرده از زمان گزارش قبلی، توانایی خودش رو در شناسایی و مختل کردن کلاهبرداریها تقویت کرده. شبکه های کلاهبرداری دیگه ای که احتمالاً منشأ اونا از کامبوج، میانمار و نیجریه بوده رو مختل کرده. این اقدامات، همراه با مختل سازیهای قبلی، بهشون اجازه میده تا برخی روندهای نوظهور در عملیات کلاهبرداری از کشورهای مختلف رو شناسایی کنن.

ترفندهای قدیمی، ابزارهای هوش مصنوعی:

اکثر فعالیتهای کلاهبرداری که مختل کردن بر اساس وارد کردن AI در گردش کاری کلاهبرداریهای موجود بود، نه ایجاد گردش کارهای جدید مبتنی بر AI. تمامی عملیات کلاهبرداری که امسال شناسایی و مسدود کردن، عمدتاً از AI بعنوان ابزار مقیاس بندی و افزایش کارایی استفاده کردن. این معمولاً شامل استفاده از مدلها برای ترجمه، نگارش پیامها و تولید محتوا برای شبکه های اجتماعی بوده. مثلا، به تازگی عملیاتهای کلاهبرداری که احتمالاً از کامبوج و نیجریه منشأ گرفته بودن و بعنوان “شرکتهای سرمایهگذاری” ظاهر میشدن تا قربانیان رو در چندین کشور فریب بدن، مسدود کردن.

کلاهبرداران سایتها و تبلیغات آنلاین ایجاد کردن تا شرکتهای جعلی رو ترویج بدن و از اکانتهای شبکه اجتماعی احتمالاً جعلی با شخصیتهای “کارشناسان معامله” استفاده کردن تا مردم رو به گروههای پیامرسان خصوصی دعوت کنن. با وعده فرصتهای سودآور و بدون ریسک، بازیگران تهدید سعی کردن قربانیان احتمالی رو به واریز پول در پلتفرمهای معاملاتی ساختگی ترغیب کنن. در همهی این کلاهبرداریها، کلاهبرداران عمدتاً از مدلها برای تولید و ترجمه مکاتبات، ایجاد محتوا برای سایتها و اکانتهای شبکه اجتماعی و انجام تحقیقات پایه استفاده کردن.

در یک مورد دیگه، یک مرکز کلاهبرداری که احتمالاً در میانمار واقع بود، از مدلها، هم برای تولید محتوا برای طرحهای کلاهبرداری و هم برای انجام کارهای روزمره استفاده میکرد. این شامل سازماندهی برنامه ها، نگارش اطلاعیه های داخلی، تخصیص میز و خوابگاه، و مدیریت حسابهای مالی بود. برخی اپراتورها درباره مجازاتهای کیفری برای افرادی که کلاهبرداری آنلاین انجام میدن هم سوال کردن.

همه ی کلاهبرداران برابرن، اما برخیشون در استفاده از AI بیشتر برابرند:

تمامی کلاهبرداران به یک شکل از مدلهای استفاده نمی کردن و پیچیدگی فعالیتها متفاوت بود. اکثر تعاملات کلاهبرداران با ChatGPT شامل کارهای نسبتاً سادهای مانند ترجمه بود، اما برخی عملیاتها بلندپروازانه تر و پیچیده تر بودن. مثلاً، یک عملیات کلاهبرداری که احتمالاً منشأ کامبوج داشت، از مدلها برای تولید بیوگرافیهای دقیق برای “کارشناسان سرمایهگذاری جعلی” و کارکنان ساختگی شرکتهای معاملاتی جعلی استفاده میکرد. بعدش کلاهبرداران از ChatGPT میخواستن پیامهای شبکه اجتماعی رو به سبک شخصیتهای ساختگی بنویسه. غالباً، بازیگران ورودیهایی که به مدل میدادن، پیامهایی بود که از اهداف خود دریافت کرده بودن و از مدل میخواستن مکالمه رو بعنوان شخصیت جعلی ادامه بده.

یک عملیات کلاهبرداری دیگه، که اون هم احتمالاً منشأ کامبوج داشت، با استفاده از مدلها، پیامکهای cold-call تولید میکرد که بصورت انبوه به شماره های آمریکایی ارسال می شدن. یکی از این پیامها به یکی از محققین OpenAI هم ارسال شده بود، مشابه موردی که در ژوئن گزارش کرده بودن. این پیامکها شامل دعوت به گروههای WhatsApp بودن، که بعداً مسدود شدن و نامشون شبیه یک شرکت سرمایهگذاری واقعی بود. بر اساس یک سری پیامهای WhatsApp که به محقق OpenAI ارسال شده بود، اگه هدف احتمالی عضو یکی از این گروهها میشد، بسرعت شاهد یک مکالمه بین حدود شش حساب مختلف بود که همگی درباره سرمایهگذاری صحبت میکردن. یکیشون “کارشناس سرمایهگذاری” بود، در حالیکه بقیه بعنوان سرمایهگذاران با درجات مختلف تجربه ظاهر میشدن. تمام بخشهای این مکالمه توسط کلاهبرداران تولید و یکجا از چینی ترجمه شده بود، احتمالاً برای ایجاد تصور گروهی پویا و موفق از معامله گران مشتاق. در نهایت، “کارشناس سرمایه گذاری” به هدف پیشنهاد میکرد که خودش هم سرمایهگذاری کنه.

یک عملیات دیگه کلاهبرداری که احتمالاً منشأ نیجریه داشت، از مدل برای دریافت راهنمایی گامبهگام درباره نحوه استفاده از تبلیغات شبکه های اجتماعی برای دسترسی به افراد ثروتمند در آمریکای لاتین، پنهان کردن موقعیت جغرافیایی و دور زدن محدودیتهای شبکه های اجتماعی استفاده کرده بود. این شامل هدایت مدل به شرایط عمومی استفاده از یک پلتفرم و درخواست بررسی محتوای تبلیغاتی پیشنهادی برای انطباق با قوانین بود.

مبهمسازی و بهانه تراشی:

کلاهبرداران، بویژه مراکز کلاهبرداری بزرگ، به فعالیتشون مصمم هستن. اغلب، واکنش اونا به اختلال ایجاد شده برای اکانتشون، تلاش برای از سرگیری فعالیتهای خلاف قانون بوده، در حالیکه برخی رفتارشون رو تغییر دادن، احتمالاً برای فرار از شناسایی بیشتر. این یکی از دلایلی است که به اشتراکگذاری اطلاعات درباره فعالیتهای در حال تحول اونا در صنعت اهمیت داره، مانند زمانیکه OpenAI و Meta اطلاعات مربوط به بازیگران تهدید رو به اشتراک گذاشتن که به تحقیقات و اجرای قوانین بیشتر کمک کرد.

احتمالاً در واکنش به اختلالات یا گفتگوهای آنلاین درباره علائمی که میتونه استفاده از AI رو آشکار کنه، مشاهده کردن که کلاهبرداران تلاش میکنن استفاده خودشون از AI رو در محتوای آنلاین و ارتباط با اهداف، مخفی کنن. این شامل عملیات کلاهبرداری احتمالاً از منشأ کامبوج است که مدل رو برای حذف em‑dashها از خروجیها هدایت میکردن.

em‑dash که در فارسی معمولاً با عنوان خط فاصله بلند یا “—” شناخته میشه، نوعی خط تیره هستش که طولش تقریباً به اندازه حرف بزرگ M هستش، به همین دلیل بهش em‑dash میگن. ازش برای جدا کردن جملات، ایجاد وقفه در جمله یا تاکید بر یک بخش خاص استفاده میشه. مثلا من میخواستم بهت زنگ بزنم — اما بعد یادم رفت.

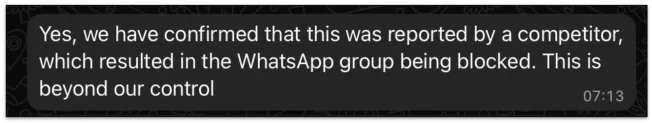

در یکی از موارد، کلاهبرداران تلاش کردن یک اختلال گسترده در داراییهای شبکه اجتماعی خودشون رو، با ساختن بهانهای برای مسدود شدن توجیه کنن. این مربوط به مرکز کلاهبرداری احتمالاً با منشأ کامبوج بود که روی SMS و WhatsApp فعالیت میکرد و قبلا توضیح داده شد. پس از مسدود شدن گروههای سرمایهگذاری مرتبط با این عملیات در WhatsApp، اپراتورها شروع به تولید پیامهایی کردن که ادعا میکرد این گروهها بطور نادرست توسط یک رقیب گزارش شدن.

مقابله با سوءاستفاده های مرتبط با رژیمهای استبدادی از هوش مصنوعی: نمونه جمهوری خلق چین (PRC)

PRC در پیشبرد نسخه استبدادی خودش از هوش مصنوعی، پیشرفتهای واقعی داره. مختل سازی اکانتهایChatGPT که توسط افرادی ظاهراً مرتبط با نهادهای دولتی چین استفاده میشد، نمایی از وضعیت فعلی استفاده از هوش مصنوعی در این محیط استبدادی ارائه میده.

توسعه ابزار برای نظارت گسترده

برخی از اکانتهایی رو که مسدود کردن، ظاهراً در تلاش بودن از ChatGPT برای توسعه ابزارهای نظارت گسترده استفاده کنن: تحلیل دادهها که اغلب از شبکههای اجتماعی غربی یا چینی جمعآوری شده بود. (در فوریه یک مورد از این نوع رو گزارش کردن که هدف اونا طراحی ابزار شنود شبکه اجتماعی مبتنی بر AI بود که اپراتورها ادعا میکردن برای نیروهای امنیتی چین است.)

این کاربران معمولاً از ChatGPT میخواستن که در طراحی چنین ابزارهایی یا تولید محتوای تبلیغاتی برای اونا کمک کنه، اما نه اجرای واقعی نظارت. مثلا، اخیراً یک کاربر که احتمالاً از VPN برای دسترسی به خدمات از چین استفاده میکرد، مسدود شد. او از ChatGPT میخواست در طراحی محتوای تبلیغاتی و برنامه ریزی پروژه برای ابزار شنود شبکه اجتماعی کمک کنه که ظاهراً برای یک مشتری دولتی بود. این ابزار بعنوان یک ابزار بررسی و جمع آوری شبکه اجتماعی (探针) توصیف شده بود که میتونست بطور ادعایی توییتر/X، فیسبوک، اینستاگرام، ردیت، تیکتاک و یوتیوب رو برای آنچه کاربر گفتار افراطی و محتوای قومی، مذهبی و سیاسی می نامید، اسکن کنه. کاربر از مدل برای انجام نظارت واقعی استفاده نکرده بود و OpenAI هم نمیتونه بطور مستقل تأیید کنه که آیا این ابزار توسط یک نهاد دولتی چینی استفاده شده یا خیر.

بطور مشابه، کاربر دوم که احتمالاً با یک نهاد دولتی مرتبط بود، از ChatGPT خواست یک پیشنهاد برای چیزی که اونا «مدل هشدار ورودی افراد مرتبط با اویغور با ریسک بالا» (高危涉维吾尔关注人员流入预警模型) توصیف کردن، بنویسه. این پیشنهاد ابزاری رو توصیف میکرد که رزروهای ترابری رو تحلیل و با سوابق پلیس مقایسه میکنه تا هشدار زود هنگام در مورد تحرکات افرادی که بعنوان مرتبط با اویغور و با ریسک بالا طبقهبندی شدن، ارائه بده. کاربر از مدل نخواسته این ابزار رو بسازه، فقط درخواست تهیه پیشنهاد کلی داشته. بنابراین، نمیشه بطور مستقل تأیید کرد، چه فناوری مدنظر اونا بوده یا آیا این ابزار توسط نهاد دولتی چینی استفاده شده یا خیر.

پروفایل سازی و تحقیقات:

OpenAI همچنین کاربرانی رو مسدود کرده که به نظر میرسه با نهادهای دولتی چین مرتبط هستن و در تلاش برای استفاده از ChatGPT برای پروفایل سازی هدفمند و تحقیقات آنلاین بودن.

برای مثال، یک کاربر از ChatGPT خواسته منابع مالی یک حساب X که دولت چین رو نقد میکرد، شناسایی کنه. کاربر دوم از ChatGPT خواسته سازمان دهندگان یک طومار در مغولستان رو شناسایی کنه. در هر دو مورد، مدل تنها اطلاعات عمومی در دسترس رو برگردونده و شامل جزئیات حساس مانند منابع مالی یا هویت سازمان دهندگان طومار نبوده.

برخی از این فعالیتها از مدلها بعنوان ابزار اوسینت (OSINT) استفاده میکردن، مشابه روشی که کاربران قبلی از جستجوهای اینترنتی یا شبکه های اجتماعی استفاده میکردن. برای مثال، یک کاربر سوم از ChatGPT خواسته اخبار روزانه مرتبط با چین، از جمله موضوعات حساس مانند سالگرد کشتار میدان تیان آنمن ۱۹۸۹ و تولد دالاییلاما رو شناسایی و خلاصه کنه.

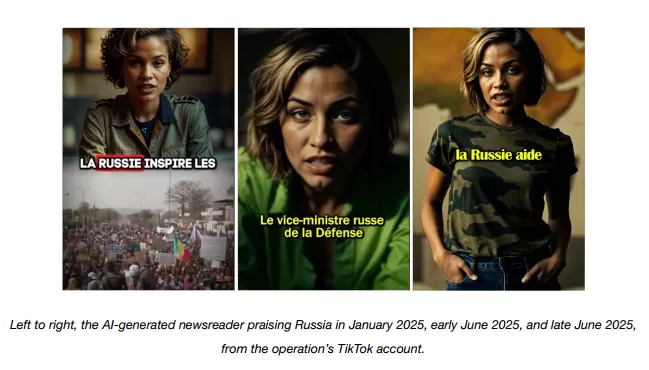

فعالیت یک نفوذ تکراری: Stop News

OpenAI مجموعهای از اکانتها رو مسدود کرده که در تلاش بودن از مدلها برای تولید محتوا در یک عملیات نفوذ استفاده کنن. این عملیات همان عملیاتی بود که در گزارش اکتبر ۲۰۲۴ با نام “Stop News” به اون اشاره شده بود. این فعالیت از روسیه منشأ گرفته و ظاهراً با یک شرکت بازاریابی مرتبط بوده. تحقیقات نشان داده که این بازیگر سعی داشته از ابزارهای هوش مصنوعی شرکتهای دیگه برای تولید ویدیو استفاده کنه، و بعدش این ویدیوها رو در YouTube و TikTok منتشر میکرده. OpenAI قادر نیست بطور مستقل تأیید کنه که در نهایت از کدام مدلها برای این ویدیوها استفاده شده.

مشابه فعالیتی که در اکتبر ۲۰۲۴ مختل کردن، این عملیات عمدتاً از مدلها برای تولید محتوا استفاده میکرد و بعدش اونارو در شبکه های اجتماعی و سایتهایی منتشر میشد که خودشون رو بعنوان همان رسانه های خبری در آفریقا و بریتانیا جا میزدن که سال گذشته درباره اشون نوشتن.

در حالیکه این فعالیت ظاهراً تلاشی برای ادامهی همان عملیات بعد از متوقف سازی بوده، تفاوتهای قابل توجهی در نسخه ی جدید مشاهده کردن:

- در حالیکه عملیات اولیه “Stop News” بطور غیرعادی از تصاویر زیاد استفاده میکرد، فعالیت جدید تمرکز بیشتری بر تولید متن داشته و تولید تصویر نادر بود. این با ارزیابی سازمان دیجیتال فرانسه VIGINUM همخوانی داره که گفته بود: از زمان انتشار گزارشهای Meta و OpenAI، استفاده از تصاویر تولید شده با هوش مصنوعی بطور چشمگیری کاهش یافته.

- این عملیات از ChatGPT برای تولید فیلمنامه ها و توضیحات ویدیویی به سبک اخبار استفاده میکرد. اپراتورها معمولاً یک متن طولانی به زبان روسی وارد میکردن و از مدل میخواستن یک فیلمنامه ویدیویی از اون بسازه. بعدش از مدل میخواستن که متن رو به فرانسوی ترجمه کنه. در مرحله بعد، مدل باید یک توضیح بهینه شده برای سئو و هشتگ ها تولید میکرد. برخی از این فیلمنامه ها در ویدیوهای کانال یوتیوب مرتبط با سایت آفریقا محور Stop News با دامنه newstop[.]africa استفاده شدن. برخی دیگه در کانالهای یوتیوب و تیکتاکی منتشر شدن که برند «Stop News» رو نداشتن. در این کانالها، یک گویندهی خبری تولیدشده با هوش مصنوعی اخبار رو میخونه. در بیشتر موارد، کلیپهای کوتاه از این گوینده با ویدیوهایی از رویدادهای مربوط به آفریقا ترکیب شده بود. به نظر نمیرسه که این گوینده با مدلهای OpenAI تولید شده باشه و این شرکت نمیتونه بطور مستقل تأیید کنه که از کدوم سرویس استفاده شده. ظاهر این گوینده در طول سال ۲۰۲۵ تغییر کرده، که در اسکرین شاتهای ویدیوهای تیکتاک قابل مشاهده هستش.

- در موارد پیشرفته تر، اپراتورها از مدلها برای تولید پرامپت های ویدیویی استفاده کردن، احتمالاً برای استفاده در مدلهای دیگه. در این حالت، ابتدا یک فیلمنامه روسی تولید میکردن، بعدش اونو به بخشهای دو جملهای تقسیم کرده و از ChatGPT میخواستن برای هر بخش، یک پرامپت ویدیویی بنویسه. پس از تولید این پرامپت ها، از مدل میخواستن کل متن رو به فرانسوی ترجمه کنه.

فعالیت این عملیات به سه دستهی اصلی تقسیم میشه:

- محتوای فرانسوی زبان: متن هایی که نقش فرانسه و ایالات متحده در آفریقا رو مورد انتقاد قرار میداد و در مقابل، از نقش روسیه تمجید میکرد.

- محتوای انگلیسی زبان: متن هایی که اوکراین و حامیان بین المللیش رو هدف انتقاد قرار میداد. در برخی موارد هم تصاویری برای همراهی با این متون تولید میشد. گاهی اوقات اپراتورها از ChatGPT میخواستن مقالات تبلیغاتی و متنهای آگهی Google Ads برای برند اصلیشون، یعنی Newstop Africa تولید کنه. برخی از این مقالات تبلیغاتی، برند Newstop رو در کنار رسانه های خبری واقعی قرار میدادن تا با تداعی سازی، اعتبار جعلی ایجاد کنن.

- محتوای تبلیغاتی تجاری: بخشی از این فعالیت، شامل تولید آگهی برای مجموعهای از شرکتهای تجاری روسی بود، از جمله تبلیغ قمار آنلاین غیرمجاز. این ترکیب محتوای تبلیغاتی تجاری و عملیات نفوذ، با الگوی فعالیت شرکتهای بازاریابی پیمانکار که سال گذشته گزارش داده بودن، سازگاره.

با وجود تمرکز بیشتر این عملیات بر محتوای ویدیویی کوتاه و استفاده پیچیده تر از چند ابزار هوش مصنوعی، محتوای منتشر شده، بازدید بسیار محدودی داشته:

- اکانت X مربوط به “Newstop Africa” تا اوت ۲۰۲۵ فقط ۱۷۲ دنبالکننده و بیشترین پست اونا تنها ۴ بازنشر داشته.

- کانالهای یوتیوب و تیکتاک که گویندهی خبری هوش مصنوعی رو نمایش میدادن، هر کدام حدود ۱۹۰۰ دنبالکننده داشتن.

- کانال تیکتاک در مجموع ۵٬۸۵۵ لایک داشته (میانگین ۱۰۵ لایک برای هر ۵۶ ویدیو). بیشترین بازدید ویدیو: ۶۳٬۳۰۰ و کمترین بازدید: ۸۷ مورد بود.

- کانال یوتیوب در مجموع حدود ۲۵۵٬۰۰۰ بازدید از ۵۰ ویدیو داشت (میانگین ۵٬۱۰۰ بازدید برای هر ویدیو). بیشترین بازدید ویدیو: ۳۷٬۰۰۰ و کمترین بازدید: ۱۲۶.

هیچ مدرکی مبنی بر بازنشر گسترده، ارجاع رسانهای یا تأثیرگذاری واقعی یافت نشد.

در گزارش اکتبر ۲۰۲۴، این عملیات رو در ردهی ۳ از “مقیاس نفوذ” (Breakout Scale) طبقه بندی کرده بودن. عمدتاً به دلیل اینکه ظاهراً چندین “شراکت اطلاعاتی” با سایتهای بریتانیایی داشت. اما تحقیقات بعدی توسط VIGINUM و محققین OSINT، نشان داد که این شراکتها احتمالاً ساختگی بوده و در واقع از نقصهای فنی در سایتهای خارجی سوء استفاده کردن تا بدون اطلاع مدیران، محتوا اضافه کنن. بنابراین، ارزیابی فعلی این که، فعالیت این عملیات بیشتر با ردهی ۲ مطابقت داره: فعالیت در چندین پلتفرم اینترنتی، اما بدون نفوذ یا تعامل قابل توجه با جوامع واقعی.

عملیات نفوذ: عملیات Nine—emdash Line

OpenAI شبکهی کوچکی از اکانتهایChatGPT رو مسدود کرده که احتمالاً با یک عملیات نفوذ با منشأ چین در ارتباط بودن و از مدلهای این شرکت برای تولید محتوا در یک عملیات نفوذ در چندین کشور استفاده میکردن. این اکانتها عمدتاً پستهایی به زبان انگلیسی تولید میکردن.

در مقیاس پایین، این عملیات محتوای انگلیسی دربارهی مسائل سیاسی در ایالات متحده تولید میکرد. اکانتهای شبکه های اجتماعی که این محتوا رو منتشر میکردن شباهتهایی با عملیات قدیمی تر با منشأ چین بنام Spamouflage داشتن (که در گزارش ماه مه ۲۰۲۴ ارائه شده بود)، اما هیچ پیوند فنی مستقیمی میان این دو عملیات شناسایی نشد. برخی از ویدیوهایی که در جدیدترین پستها به اشتراک گذاشته شدن، پیش تر توسط مؤسسه سیاست راهبردی استرالیا (ASPI) در عملیاتی مشابه با Spamouflage شناسایی شده بودن.

تمرکز اصلی این شبکه به نظر میرسه تولید انبوه پستهای شبکه اجتماعی دربارهی کشورهایی باشه که با چین در دریای چین جنوبی (یا دریای غربی فیلیپین) اختلاف ارضی دارن. چین مدعی حاکمیت بر بیشتر این منطقه است و مرز خودش رو با خطوطی معروف به “Nine-Dash Line” مشخص کرده. ادعایی که بر اساس قوانین بین المللی مورد اعتراض ویتنام، فیلیپین و دیگر کشورهاست. با توجه به این زمینه و اینکه در پستهای تولید شده توسط این عملیات از نشانه های خط بلند (em-dash) استفاده شده بود، این عملیات بنام “Nine—emdash Line” نامگذاری شد. بیشتر پستها در شبکهی X منتشر میشدن.

علاوه بر تولید پست، این بازیگران از مدلهای این شرکت برای برخی وظایف تحقیقاتی و شناسایی (Reconnaissance) هم استفاده کردن. برای نمونه:

- شناسایی وبلاگها و انجمنهای کوچک یا کمتر قانونمند در اروپا، آمریکا و جنوب شرق آسیا

- درخواست فهرستهایی از اسامی متداول تبتی. رفتاری که در دیگر موارد هم مشاهده کردن، زمانیکه عاملان از این نامها برای ساخت اکانتهای جعلی استفاده میکردن.

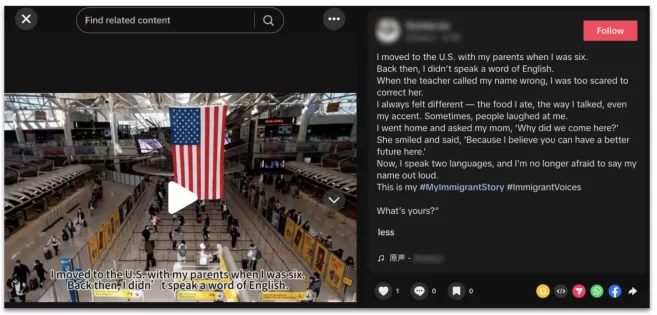

این نوع استفاده شبیه به جستجوهای سنتی اینترنتی بود و نتایج مشابهی برمیگردوند که نشان میده، استفادهی عاملان از هوش مصنوعی بیشتر برای سهولت و سرعت کار بوده، نه افزایش واقعی توان فنی. استفادهی جدید و جالب این شبکه، درخواست برای مشاوره در مورد رشد در شبکه های اجتماعی بود، از جمله:

- چگونگی راه اندازی یک چالش در TikTok

- تشویق دیگران به تولید محتوا دربارهی هشتگ MyImmigrantStory (هشتگی قدیمی و پرکاربرد که عملیات احتمالاً قصد سوء استفاده از محبوبیت اونو داشت).

اونا از مدل میخواستن:

- ایده پردازی کنه.

- متن ویدیوی TikTok رو بنویسه.

- براش موسیقی پس زمینه و تصاویر مناسب پیشنهاد بدهد.

با استفاده از روشهای اوسینت، محتوای تولید شدهی این عملیات در TikTok شناسایی شدن.

موضوعات پستهای انگلیسی تولید شده توسط این شبکه شامل موارد زیر بود:

- اتهام آسیب زیست محیطی ویتنام در دریای چین جنوبی

- بحران فنتانیل در ایالات متحده

- پستهایی که مدعی بودن رئیسجمهور فیلیپین مارکوس درگیر مصرف مواد مخدره و از تاکتیکهای تقلب انتخاباتی استفاده کرده.

ویدیویی که همراه با این پستها منتشر شد، توسط مدلهای OpenAI تولید نشدن و قبلا توسط دولت فیلیپین بعنوان “دیپ فیک” (deepfake) یا “دستکاری دیجیتالی” افشا شده بود.

بسیاری از اکانتهای X که این محتوا رو منتشر کردن، اکنون تعلیق شدن. این اکانتها همچنین درخواست مجموعه های بزرگی از نظرات به زبان کانتونی داشتن که در X و Instagram منتشر شدن و چهره های سیاسی و فعالان دموکراسی خواه هنگکنگ مانند: Jimmy Lai، Nathan Law و Agnes Chow رو تحقیر یا بدنام میکردن. این پستها قصد داشتن این افراد رو خائن یا مجرم جلوه بدن. در مقابل، برخی پستها از قوانین امنیت ملی هنگکنگ حمایت میکردن.

در یک مورد غیرعادی، یکی از بازیگران در X پستی انتقادی علیه چهره های دموکراسی خواه منتشر کرد و بعدش با اکانت دیگه ای به همان پست پاسخ داد و از همان چهره ها تعریف و تمجید کرد! به این ترتیب دو حساب متفاوت برای ایجاد بحث ساختگی دوطرفه استفاده شدن.

با وجود حجم زیاد محتوای منتشر شده در چندین پلتفرم، OpenAI ارزیابی میکنه که این عملیات در مقیاس Breakout (تأثیر عملیات اطلاعاتی) در ردهی ۲ قرار داره: فعالیت در چند پلتفرم اینترنتی، اما بدون نفوذ یا تعامل واقعی قابلتوجه.

بیشتر پستها و اکانتها هیچ بازخورد یا تعامل معناداری دریافت نکردن. اغلب تنها پاسخها یا بازنشرها توسط اکانتهای دیگه متعلق به همان بازیگران انجام میشد. پرسوناهای استفاده شده توسط این اکانتها هماهنگ اما ابتدایی بودن و ویژگیهایی مشابه دیگر عملیات نفوذ با منشأ چین داشتن، مانند:

- استفاده از هشتگها و تصاویر منتشر شده در عملیاتهای قبلی

- استفاده از عکسهای استوک یا عکس پیشفرض بعنوان تصویر پروفایل

- نامهای کاربری عمومی و تکراری.

همین ویژگیها باعث شناسایی آسان اونا شد. تداوم فعالیت این شبکه حتی بعد از مسدود شدن اکانتهای ChatGPT، توسط Philstar.com شناسایی و افشا شد. این سایت بطور مستقل بخشی از شبکهی X رو کشف کرده بود که پس از مسدودسازی توسط OpenAI همچنان فعال بود.